1:音の正体と性質

Contents

サウンドベーシック:音楽の「音」

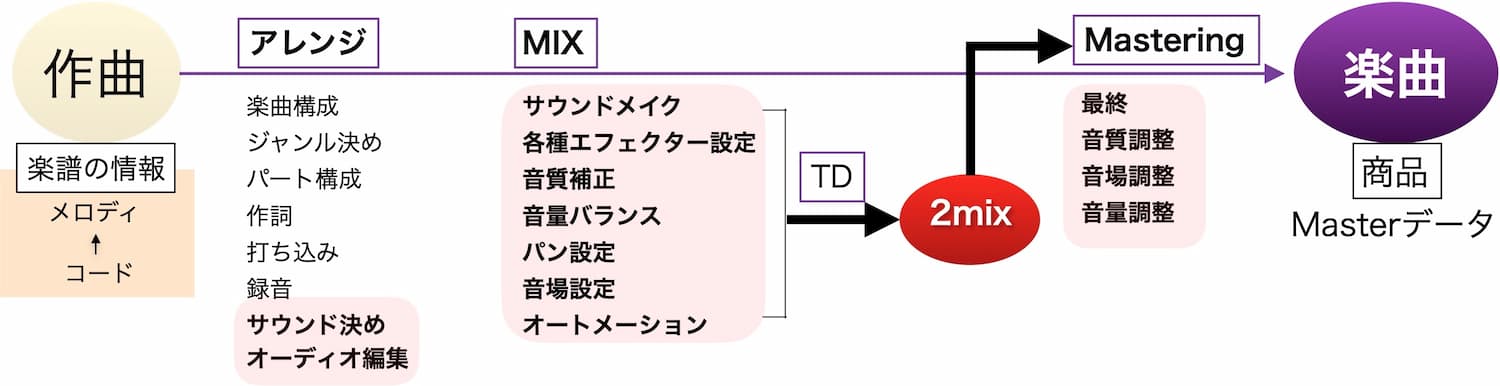

音楽の商品はCDや各種ファイルデータなどの形になる「楽曲」と呼ばれます。

楽曲は作曲された素体からアレンジ・録音等各種の作業・イベントを通じて作り上げられ、最終的にはMastering工程を経て楽曲データとして完成します。

楽曲制作工程において上記の太字でカラーに囲まれた部分が耳に実際に聴こえている「音=サウンド」の作業部分です。

いかにサウンドメイクの作業比重が多いかがわかります。

「音」の正体と性質

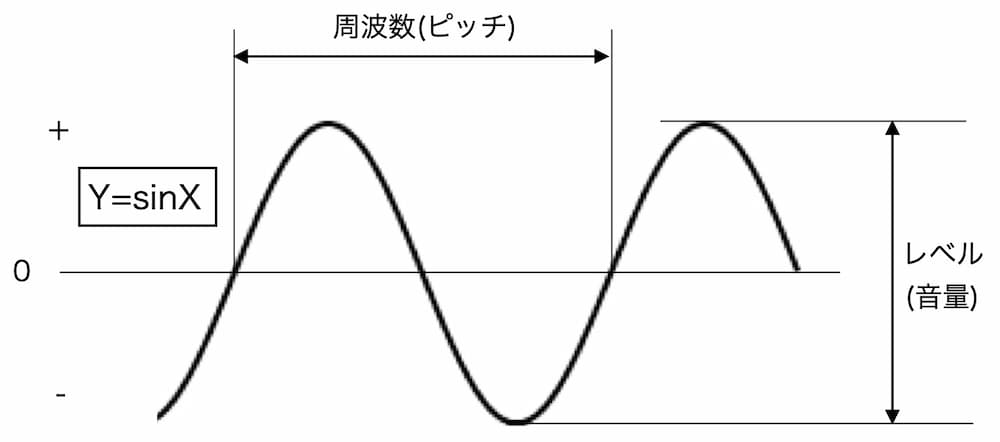

音は「音高」と「音量」で表されます。

そしてその実態は空気の振動です。

空気を振動させるものはスピーカーやイヤフォン、自然楽器や声です。

そしてその正体は「エネルギー」です。

われわれの耳は音を20Hz~20KHzという周波数範囲で感知します。

音楽で使われる様々な楽器の音、声、ノイズ等どんな音でも、バラバラに分解(フーリエ解析という)することが出来ます。

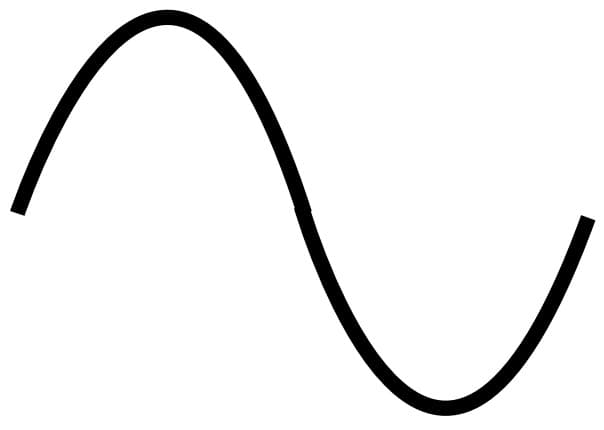

そしてこれ以上単純に出来ない音の要素を「純音」と呼びます。

これは単一のサイン波のことです。

逆をいえば全てのサウンドはサイン波の重ね合わせによって作られまず。

サウンドメイクとは周波数と音量の調整作業にほかなりません。

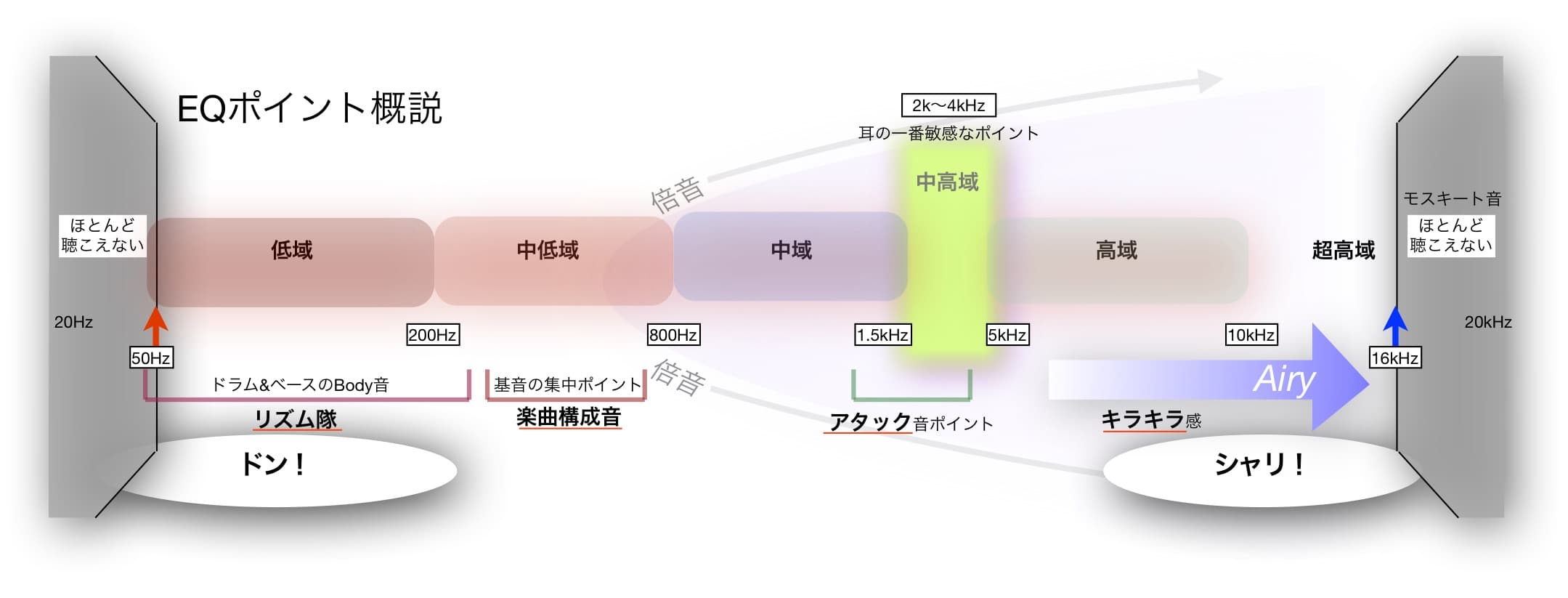

実は耳の感度は周波数によって大分感度が異なります。

可聴範囲内での標準的楽曲の成分と各周波数ポイントは以下の図になります。

サウンドメイクでの重要アイテム「イコライザー」を操作する上でとても重要な基準となります。

「音場」という考え方

実際に音が鳴るには空気の振動が不可欠です。

即ち、耳と音との間には必ず「空間」が存在します。

音が鳴っている空間環境を「音場」といいます。

DTM上のサウンドメイクにおいては「空間系」と呼ばれるエフェクター群でそれらを再現します。

主に「Delay」と「Reverb」が使われます。

大体のトラックでサウンドをつくり上げる場合は一部のパートを除いて空間系エフェクトが不可欠となっています。

実際には「障害物のある空間」「閉じた空間」「濁った空気」でない場合はほぼ原音通りの音(Dry音)となります。

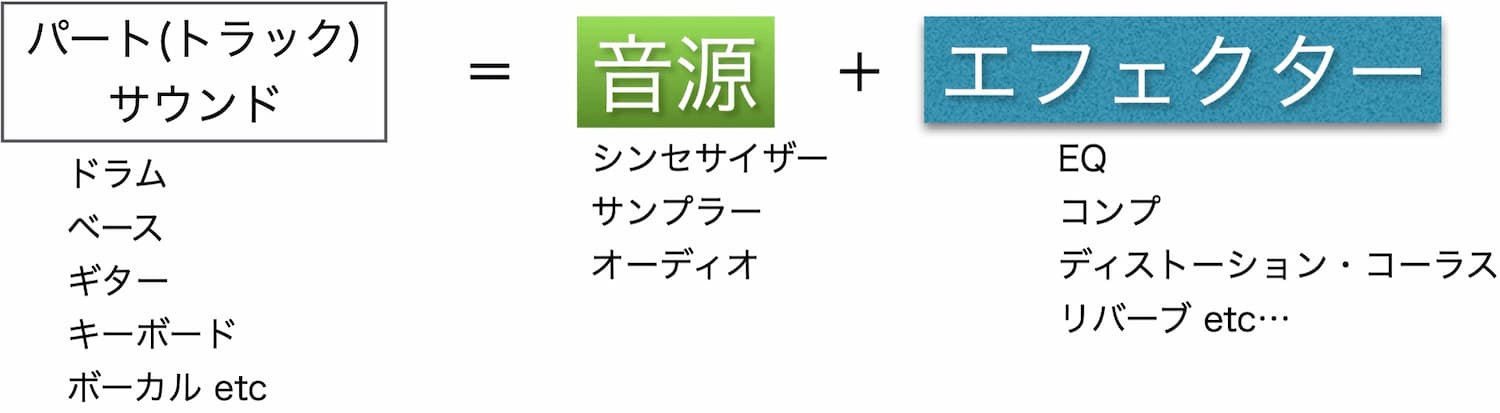

「音」と「音場」を再現するツール

サウンドは「音場」で「音」が鳴っているものと言えます。

「音」を発生させるものは「音源」、「音場」を再現するものは空間系の「エフェクター」です。

一般的に次のように定義できます。

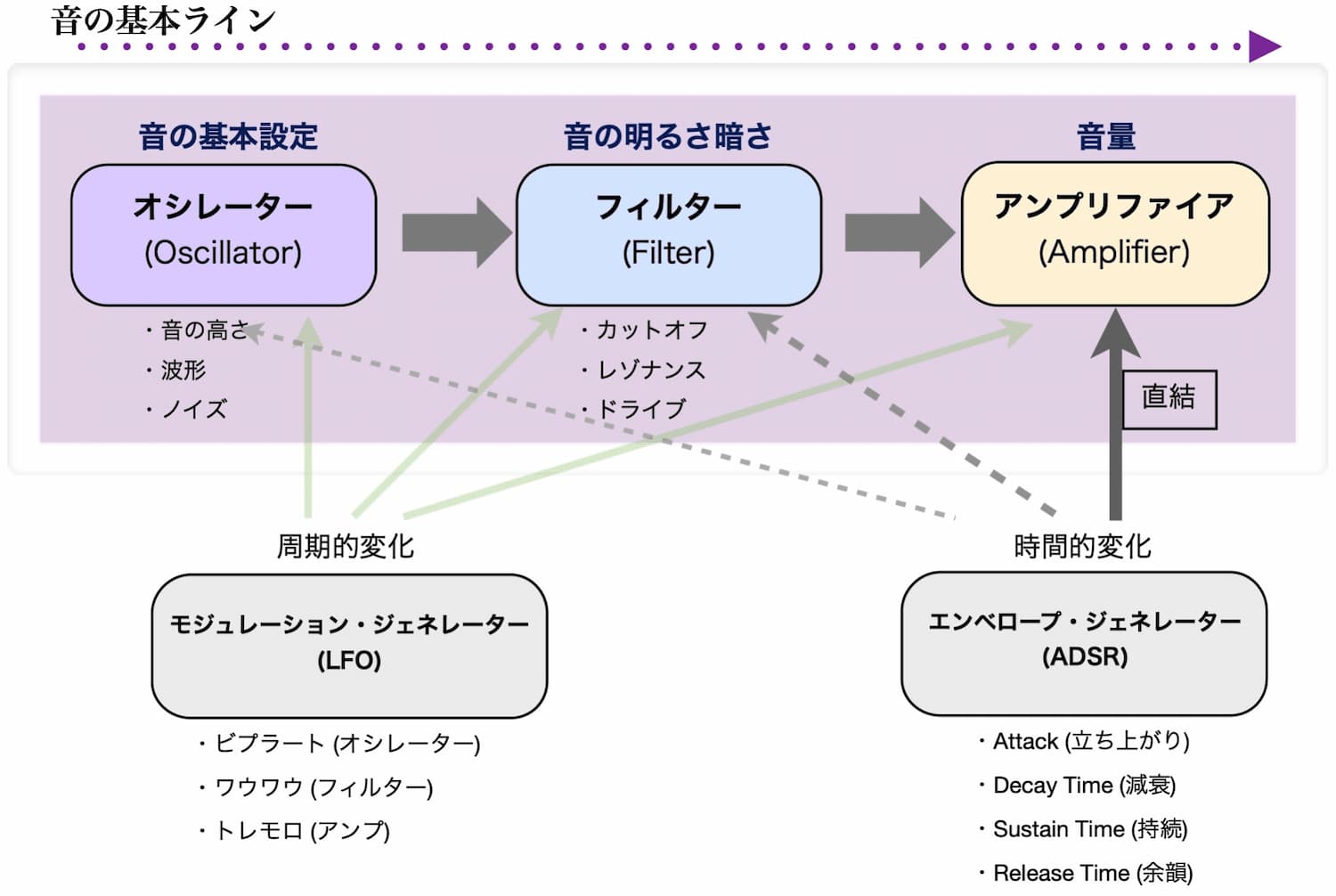

シンセサイザーとエフェクターについて

ギター・ベース・ドラム等様々な楽器群や人の声などの中でも最も自由度が高く、サウンドの幅が広いものが「シンセサイザー」です。

シンセサイザーとは

音の元となる波形を発生させて質感をコントロールし、時間軸的変化や周期的変化を様々に加えてサウンドを作り上げていくもの。

サウンドの素体部分。

エフェクターとは

空間系に代表されるように音源に対して様々な効果をつけるもの。

素体を化粧していくイメージ。

膨大な種類があるがカテゴリー別に考えると理解しやすい。

「サウンド」としてとらえた場合音源以上に影響がある場合が多い。

| ダイナミクス系 | 主に音量をコントロールする。 コンプレッサー・リミッターなど。 もっとも難易度が高い。 |

| EQ・フィルター系 | 周波数ポイントを調整する。 個々のトラックからトータルミックスまで使用頻度は一番高い。 パラメトリック・シェルビング・カットオフ型がある。 フィルターはEQの一種とも言える。 |

| 歪み系 | 過大入力で音を歪ませる。 アンプの素子、アナログ回路、デジタル方式等で歪み方やカラーが変わる。 |

| モジュレーション系 | 通称「うねり系」おもに原音と少しだけ遅らせた音とを混ぜで作り出す。 フェイザー・コーラス・フランジャー |

| 空間系 | エフェクターの基本。 はっきりと分かる時間で遅れてきた音を混ぜることで得られる「エコー効果」を基本とする。 エコーはディレイと同義。 ディレイの集合がリバーブとなる。 空間を作り出すエフェクター。 |

「音」の実態 波動

音の実態は空気の振動であり、波動として表されます。

波動の最も単純な形は「サイン波」であり、すべての音はサイン波の重なりで作られます。

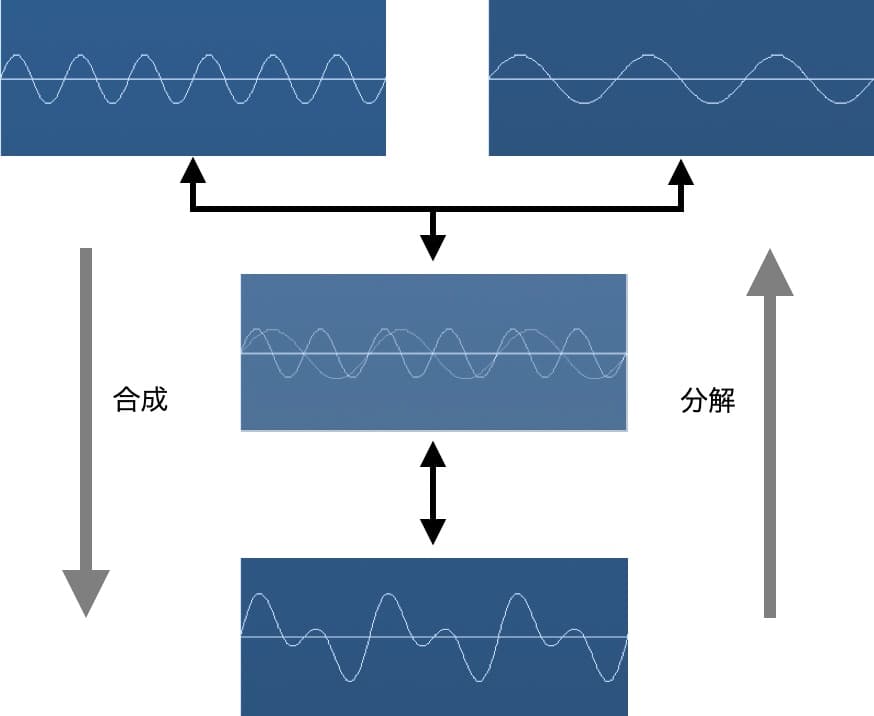

サイン波の合成と分解

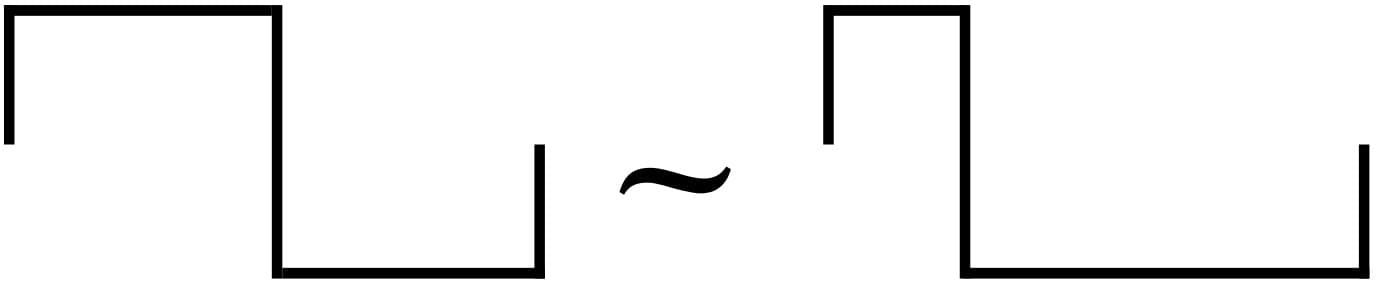

図の通り、サイン波は合成と分解ができます。

様々な音源が一度に鳴ろうとも、音源全ての波動が合成されて「1本の線」として耳に届きます。

逆に全ての音はサイン波に分解することができます。

全可聴域のサイン波を稠密に用意し、時間軸上でその音量を制御できればあらゆる音の合成が可能になります。

この音声合成(シンセサイズ)方式を「倍音加算合成方式」と呼び、究極のシンセサイザーと呼ばれます。

しかし完全な倍音加算合成方式によるシンセサイザーはまだ登場していません。

ちなみに電子オルガンなどは単純化した倍音加算方式のシンセサイザーとみなすことができます。

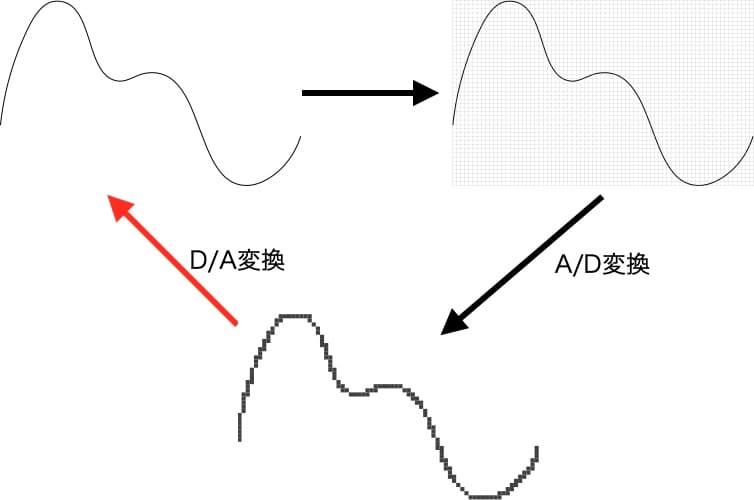

音のデジタル化(PCM=符号化変調)

DAWで扱われている音データ、PC上の音楽ファイル、CD音源、これらはすべて音声信号をデジタルデータに変換したものです。

音声信号をデジタルデータ化する技術を「PCM=符号化変調」、そしてアナログ信号である音声信号をPCMでデジタルデータに置き換えることを「A/D変換」といいます。

その逆は「D/A変換」であり、オーディオインターフェースは「A/D変換」と「D/A変換」を併せ持ったもののことです。

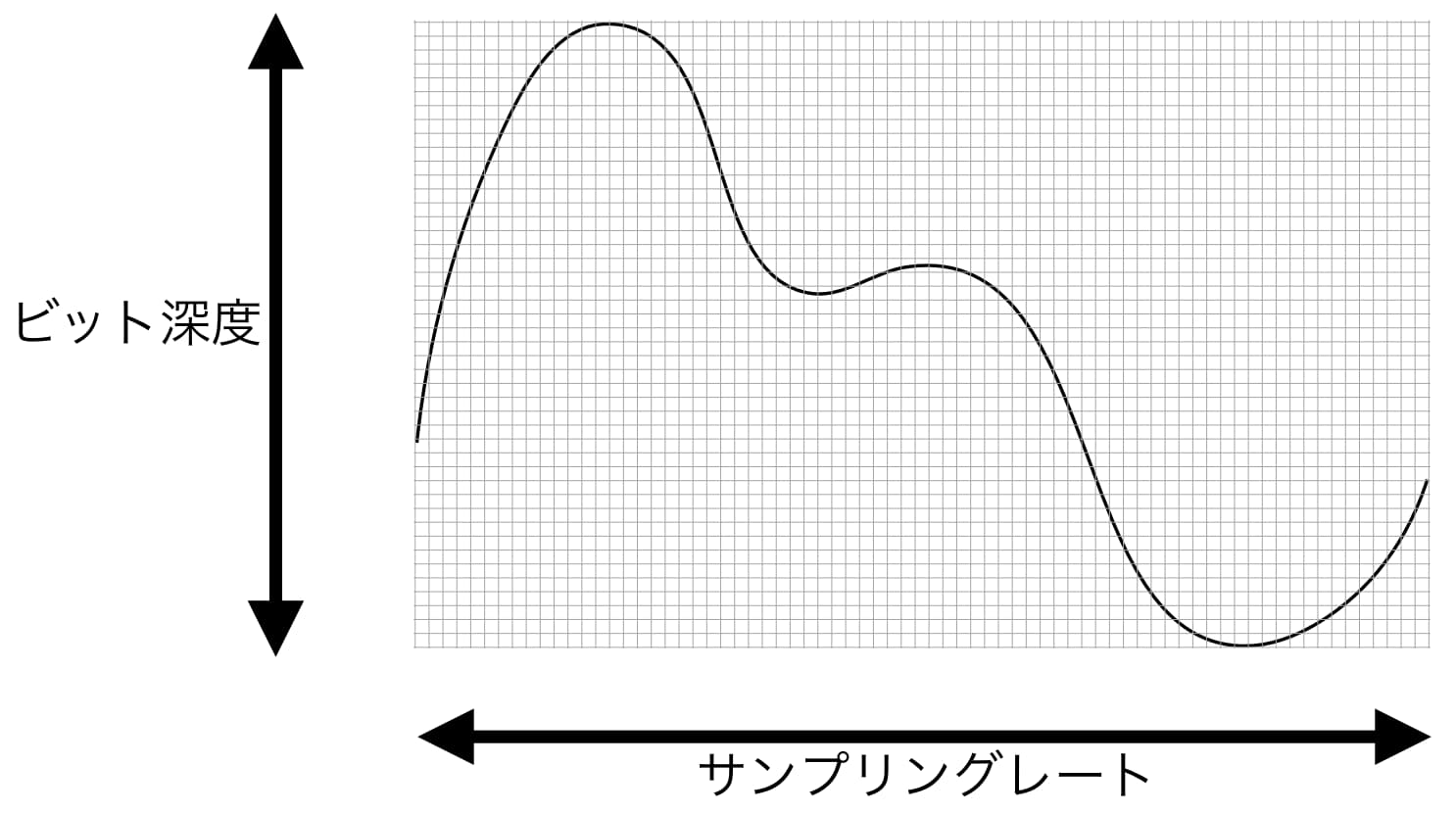

アナログ信号を網目にかけて網目のマスにデータがあるかないか(0か1か)でデジタル化します。

この網目が細ければ細かいほど元のアナログ信号に忠実なデータとなります。

網目の縦軸が音量、横軸が音高(ピッチ)を表し、音量はビット深度、音高はサンプリングレートで表します。

この両方を合わせてビットレートと呼びます。

CD企画は[16bit44.1Khz]です。

これはビット深度(音量)が2の16乗=65536段階、音高が44100Hz/秒の細かさで表現できることを意味します。

ところで波動は必ず0ポイントからのプラスとマイナス領域を行き来する形を取るので最小の波データでも2ポイントが必要です。

よって実際には44100Hzの半分=22050Hzまでの高さの音までが表現できることになります。

これをサンプリング定理と呼びます。

音色=基音+倍音

- 基音=その音の持つ最も低いサイン波

- 倍音=基音から整数倍の周波数であるサイン波

- サイン波=純音(厳密には自然界に存在しない)

音色とシンセサイザーの種類(音声合成方式の違い)

同じ高さの音の聞こえ方の違いは「音色」と表現されます。

「音色」は基音に複数の倍音が足されることによりつくられ、倍音成分でその違いが認識されます。

シンセサイザーのオシレーターに格納されている各波形は、倍音成分をパターン化して含ませたものです。

最もシンセサイザーで使われている倍音減算方式は、各波形からフィルターなどで倍音を削って音を作り上げていく方法です。

またFM音源と呼ばれるシンセサイザーはオシレーター(キャリア:主にサイン波)をオシレーター(モジュレーター)で変調させることで新たな倍音を生成させて音色を作ります(=倍音乗算方式)。

「音色」生成後には、時間的変化や(エンベロープ・ジェネレーター)周期的変化(モジュレーションジェネレーター)を加えて音をつくり上げます。

各シンセサイザー方式も、この「音色」の生成後の処理はほぼ同じです。

基本波形

サイン[正弦]波(sine wave)

倍音を全く含まない「純粋な音」。口笛や音伹、ギターのハーモニクスなどの音に似ている。

自然界に厳密には存在しない。

FM音源などでは主にサイン波同士を掛け合わせて新たな倍音を得て音色を作る。

ノコギリ[鋸歯状]波(saw wave)

すべての倍音を含む。

バイオリン、ブラス、シンセベース、パッドなどオールラウンドな波形。

1オクターブの音を重ねると弦を弾く音(ギターやチェンバロなど)に近くなる。

三角波(triangle wave)

奇数倍音だけを含む。サイン波に近いが少し鋭い音になる。

エレピやピッコロ、リコーダーなどの音に近くなる。

パルス[矩形]波(pulse wave)

奇数倍音だけを含む。

クラリネットや、ファミコンでおなじみの音。

上下の振幅幅が同じの音を特に「スクエア[方形]波(square wave)」という。

幅が変わることにより鼻にかかったような音に変化し、サックス・オーボエなどの音に近くなる。

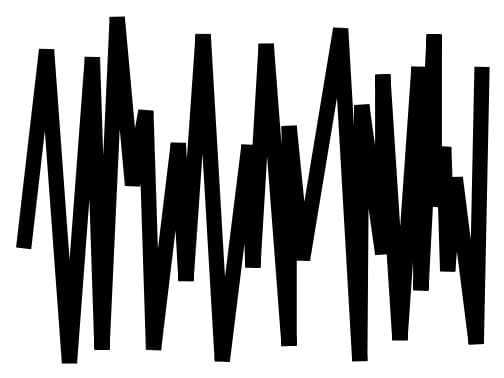

ノイズ(noise)

すべての周波数音を一斉に鳴らすとノイズになる。

通常ホワイトノイズが使われる。

色のスペクトラムにちなんで他にもブルー・ピンク・レッド・バイオレットノイズ等がある。

各シンセサイザーのインターフェース

LogicPro付属シンセ es1

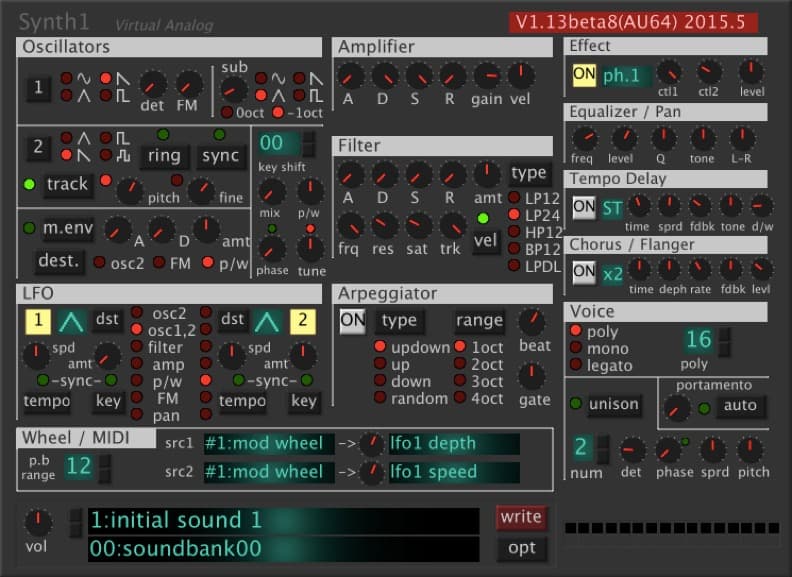

フリーシンセ Synth1

Native Instruments MONARK

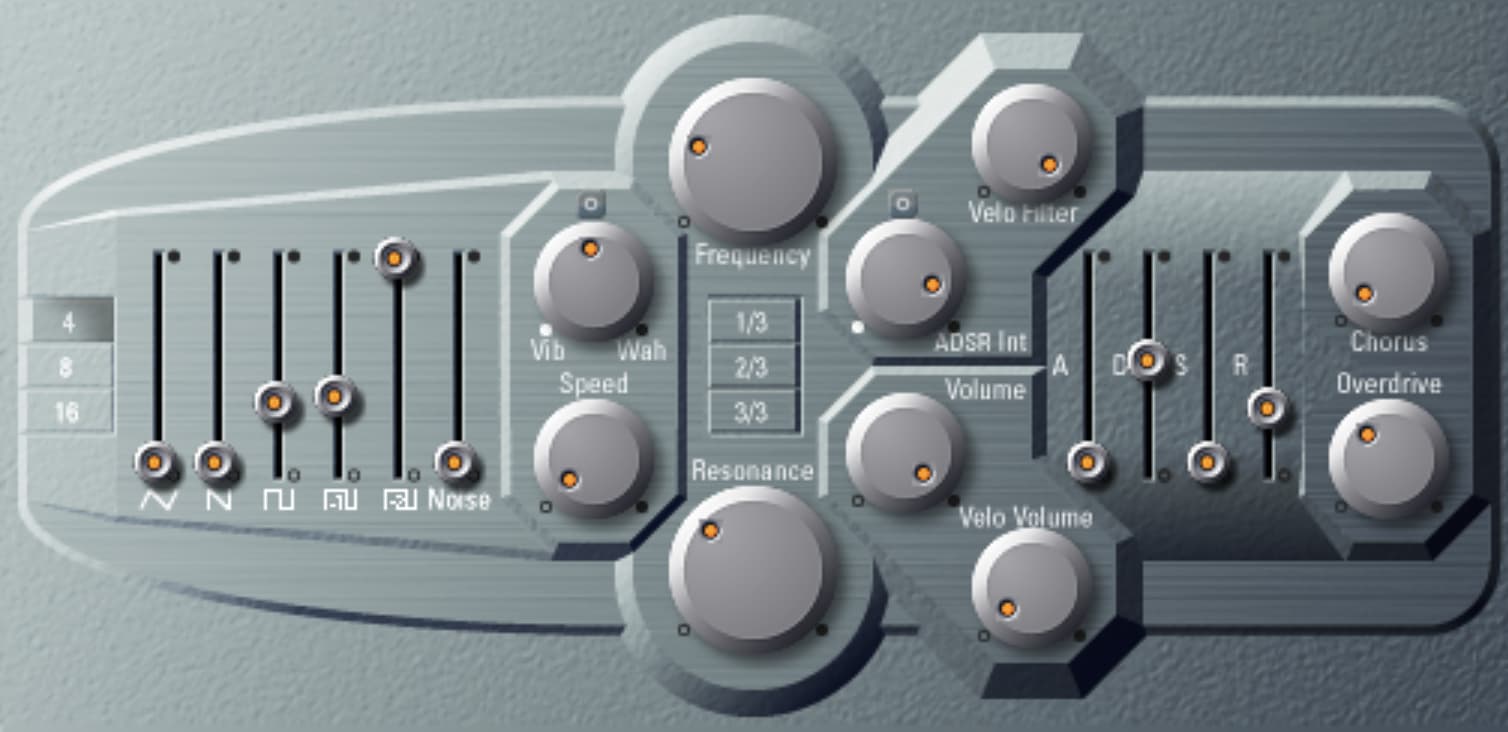

LogicPro ESP